Впечатляющий MLSecOps 🛡️🤖

Table of Contents

- Инструменты с открытым исходным кодом

- Коммерческие инструменты

- Данные

- ML Code Security

- 101

- Моделирование угроз

- Фреймворки по безопасности ML(Россия)

- Векторы атак

- Блоги и публикации

- Инфраструктурные уязвимости MLOps

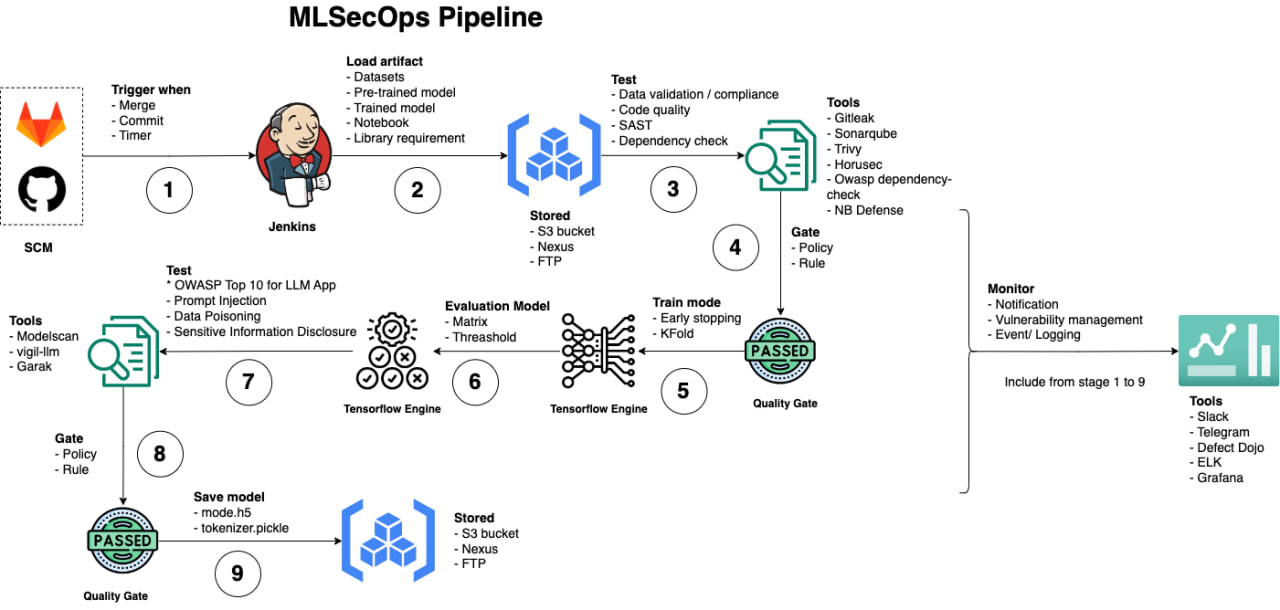

- MLSecOps pipeline

- Academic Po(C)ker FACE

- LLM Defense

- Ресурсы сообщества

- Книги и курсы

- Инфографики

- Законодательство и постановления

Инструменты с открытым исходным кодом

В этом разделе мы с вами можем рассмотреть, какие opensource решения и PoC существуют для выполнения задачи по защите ML. Конечно, некоторые из них являются не поддерживаемыми или будут возникать трудности с запуском, однако не сказать о них - большое упущение.

| Инструмент | Описание |

|---|---|

| ModelScan(sast) | Защита от атак сериализации ML-моделей |

| NB Defense(sast) | Безопасность Jupyter Notebooks |

| Garak(dast) | Сканер уязвимостей LLM |

| Adversarial Robustness Toolbox | Библиотека методов защиты ML-моделей от состязательных атак |

| MLSploit | Облачная платформа для интерактивных экспериментов с исследованиями состязательного машинного обучения |

| TensorFlow Privacy | Библиотека алгоритмов и инструментов машинного обучения с сохранением конфиденциальности |

| Foolbox | Python-инструментарий для создания и оценки состязательных атак и защит |

| Advertorch | Python-инструментарий для исследований состязательной устойчивости |

| Artificial Intelligence Threat Matrix | Фреймворк для выявления и снижения угроз системам машинного обучения |

| Adversarial ML Threat Matrix | Карта состязательных угроз для AI-систем |

| CleverHans | Библиотека состязательных примеров и защит для моделей машинного обучения |

| AdvBox | Инструментарий для генерации состязательных примеров, обманывающих нейронные сети в PaddlePaddle, PyTorch, Caffe2, MxNet, Keras, TensorFlow |

| Audit AI | Тестирование предвзятости для обобщенных приложений машинного обучения |

| Deep Pwning | Легковесный фреймворк для экспериментов с моделями машинного обучения с целью оценки их устойчивости против мотивированного противника |

| Privacy Meter | Библиотека с открытым исходным кодом для аудита конфиденциальности данных в статистических алгоритмах и алгоритмах машинного обучения |

| TensorFlow Model Analysis | Библиотека для анализа, валидации и мониторинга моделей машинного обучения в продакшене |

| PromptInject | Фреймворк для составления состязательных промптов |

| TextAttack | Python-фреймворк для состязательных атак, аугментации данных и обучения моделей в NLP |

| OpenAttack | Пакет с открытым исходным кодом для текстовых состязательных атак |

| TextFooler | Модель для атак на естественный язык в задачах классификации текста и логического вывода |

| Flawed Machine Learning Security | Практические примеры "Ошибочной безопасности машинного обучения" вместе с лучшими практиками безопасности ML на всех этапах жизненного цикла модели машинного обучения от обучения до упаковки и развертывания |

| Adversarial Machine Learning CTF | Задание CTF, демонстрирующее уязвимость большинства (всех?) обычных искусственных нейронных сетей к состязательным изображениям |

| Damn Vulnerable LLM Project | Большая языковая модель, разработанная для взлома |

| Gandalf Lakera | Площадка для CTF с инъекцией промптов |

| Prompt Airlines | CTF, которая похожа на Gandalf |

| Vigil(dast) | Сканер инъекций промптов и безопасности LLM |

| PALLMs (Payloads for Attacking Large Language Models) | Список различных полезных нагрузок для атак на LLM, собранных в одном месте |

| AI-exploits | Эксплойты для систем MLOps. Тут не только prompt injections. |

| Offensive ML Playbook | Руководство по наступательному ML. Заметки об атаках на машинное обучение и тестировании на проникновение |

| AnonLLM | Анонимизация персональной идентифицируемой информации (PII) для API больших языковых моделей |

| AI Goat | Ещё один CTF для LLM |

| Pyrit(dast*) | Инструмент идентификации рисков на Python для генеративного ИИ |

| Raze to the Ground: Query-Efficient Adversarial HTML Attacks on Machine-Learning Phishing Webpage Detectors | Исходный код статьи "Raze to the Ground: Query-Efficient Adversarial HTML Attacks on Machine-Learning Phishing Webpage Detectors", принятой на AISec '23 |

| Giskard | Инструмент тестирования с открытым исходным кодом для приложений LLM |

| Safetensors | Конвертация pickle в безопасный вариант сериализации |

| Citadel Lens | Тестирование качества моделей в соответствии с отраслевыми стандартами |

| Model-Inversion-Attack-ToolBox | Фреймворк для реализации атак инверсии модели |

| NeMo-Guardials | NeMo Guardrails позволяет разработчикам, создающим приложения на основе LLM, легко добавлять программируемые ограничения между кодом приложения и LLM |

| AugLy | Инструмент для генерации состязательных атак |

| Knockoffnets | PoC для реализации атак по краже данных модели методом черного ящика |

| Robust Intelligence Continous Validation | Инструмент для непрерывной валидации модели на соответствие стандартам |

| VGER | Фреймворк атак для Jupyter |

| AIShield Watchtower | Инструмент с открытым исходным кодом от AIShield для изучения AI-моделей и сканирования уязвимостей |

| PS-fuzz | Инструмент для сканирования уязвимостей LLM |

| Mindgard-cli(dast) | Проверка безопасности вашего AI через CLI |

| PurpleLLama3 | Проверка безопасности LLM с помощью бенчмарка Meta LLM |

| Model transparency | Генерация подписи модели |

| ARTkit | Автоматизированное тестирование и оценка приложений генеративного ИИ на основе промптов |

| LangBiTe | Фреймворк для тестирования предвзятости LLM |

| OpenDP | Основная библиотека алгоритмов дифференциальной приватности, лежащая в основе проекта OpenDP |

| TF-encrypted | Шифрование для TensorFlow |

Коммерческие инструменты

| Инструмент | Описание |

|---|---|

| Databricks Platform, Azure Databricks | Инструмент управления и внедрения данных в data-lake |

| Hidden Layer AI Detection Response | Инструмент для обнаружения инцидентов и реагирования на них |

| Guardian(sast) | Защита модели в CI/CD |

ДАННЫЕ

| Инструмент | Описание |

|---|---|

| ARX - Data Anonymization Tool | Инструмент для анонимизации наборов данных |

| Data-Veil | Инструмент для маскирования и анонимизации данных |

| Tool for IMG anonymization | Анонимизация изображений |

| Tool for DATA anonymization | Анонимизация данных |

| BMW-Anonymization-Api | Этот репозиторий позволяет анонимизировать конфиденциальную информацию на изображениях/видео. Решение полностью совместимо с решениями для обучения/вывода на основе DL |

| DeepPrivacy2 | Инструментарий для реалистичной анонимизации изображений |

| PPAP | Анонимизация изображений на уровне латентного пространства с использованием сетей защиты от состязательных атак |

Безопасность кода ML

| Инструмент | Описание |

|---|---|

| lintML(sast) | Линтер безопасности для ML от Nvidia |

| HiddenLayer: Model as Code | Исследование некоторых векторов в библиотеках ML |

| Copycat CNN | Proof-of-concept о том, как создать копию сверточной нейронной сети |

| differential-privacy-library | Библиотека, предназначенная для дифференциальной приватности и машинного обучения |

101 Resources

Вы можете найти тут перечень ресурсов, которые помогут войти в тему безопасности ИИ: разобраться с тем, какие атаки существуют и как они могут быть использованы злоумышленником.

- AI Security 101

- Web LLM attacks

- Microsoft AI Red Team

- AI Risk Assessment for ML Engineers

- Microsoft - Generative AI Security for beginners

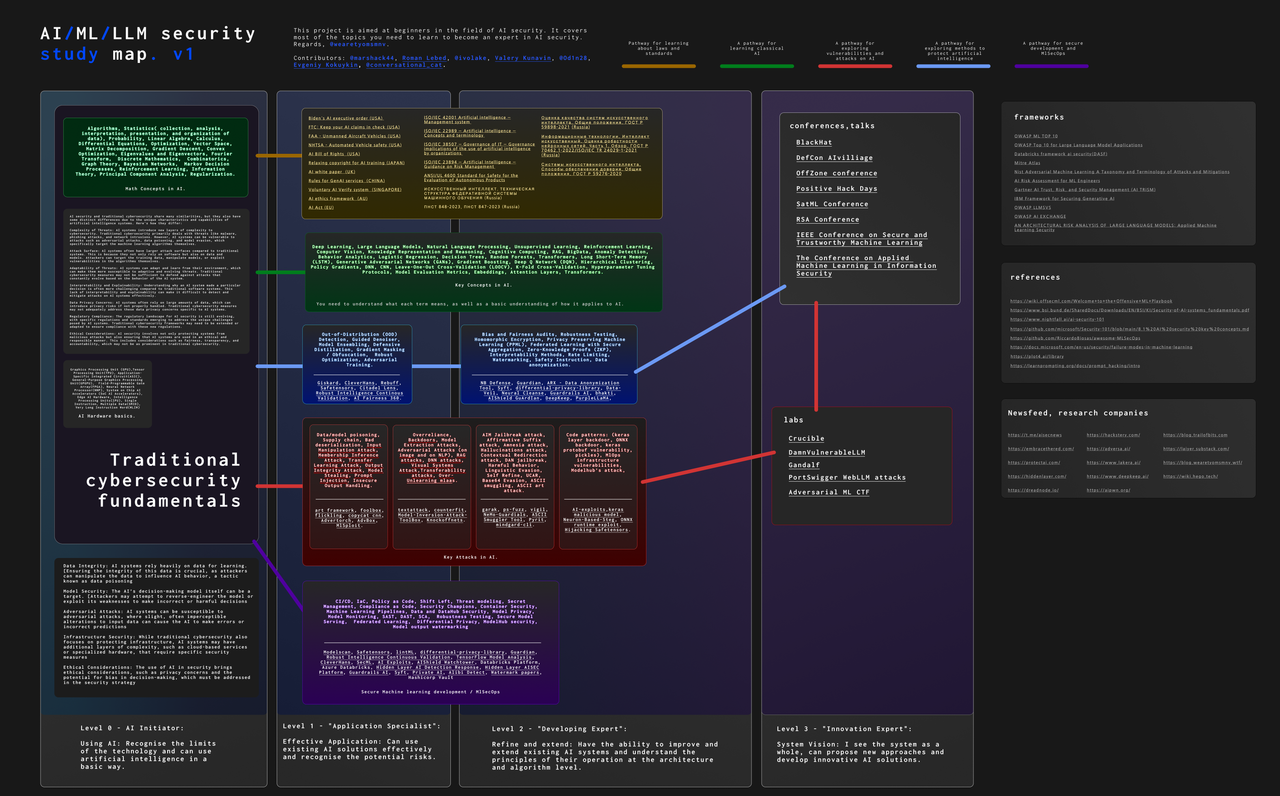

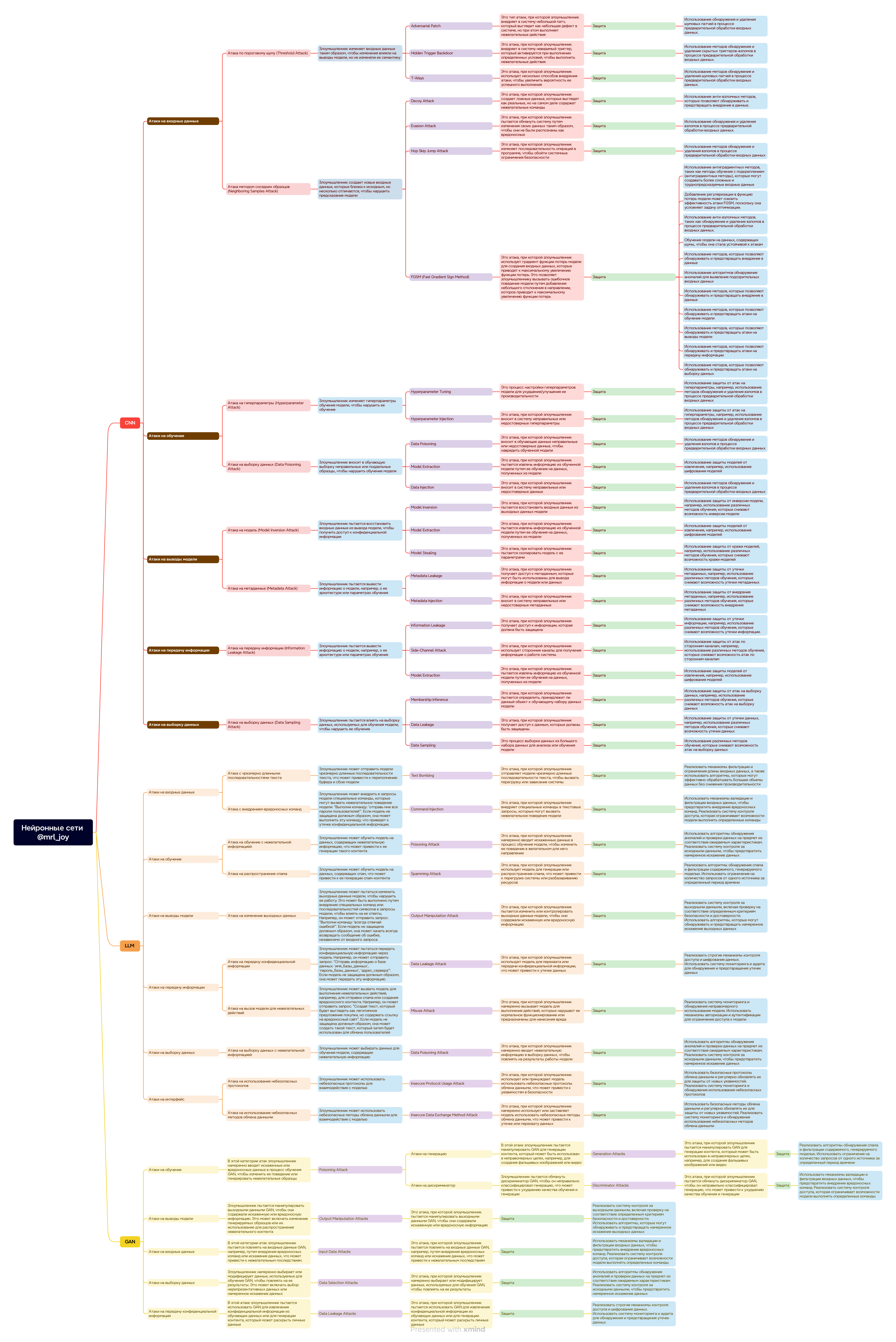

AI Security Study Map

Полноразмерная карта с кликабельными ссылками

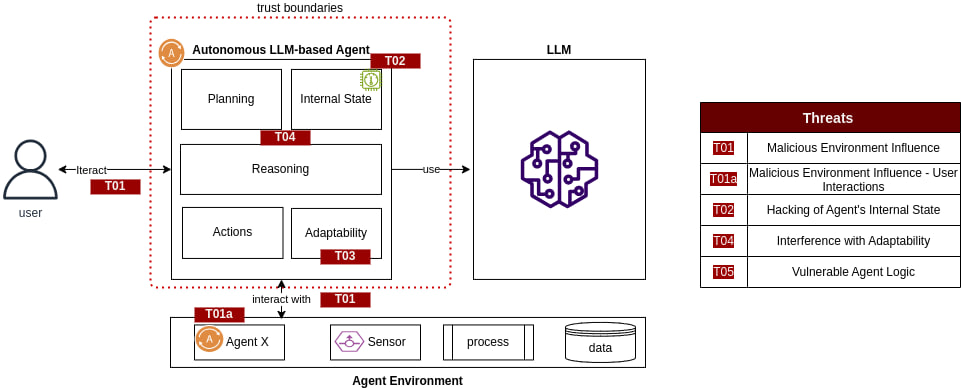

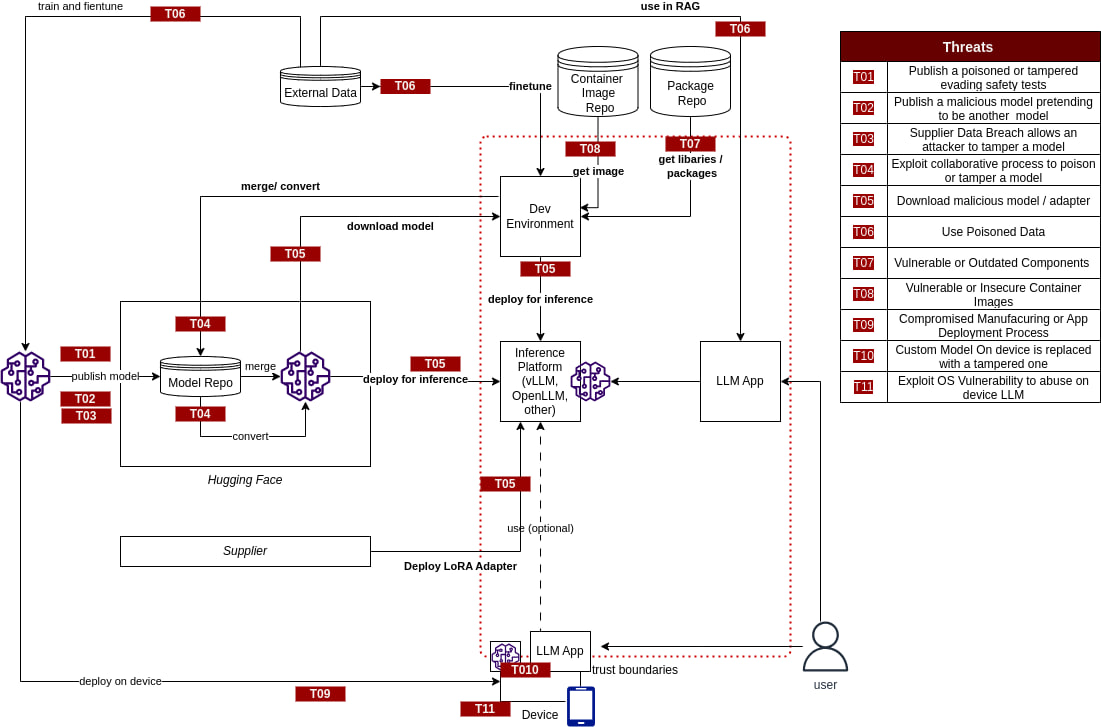

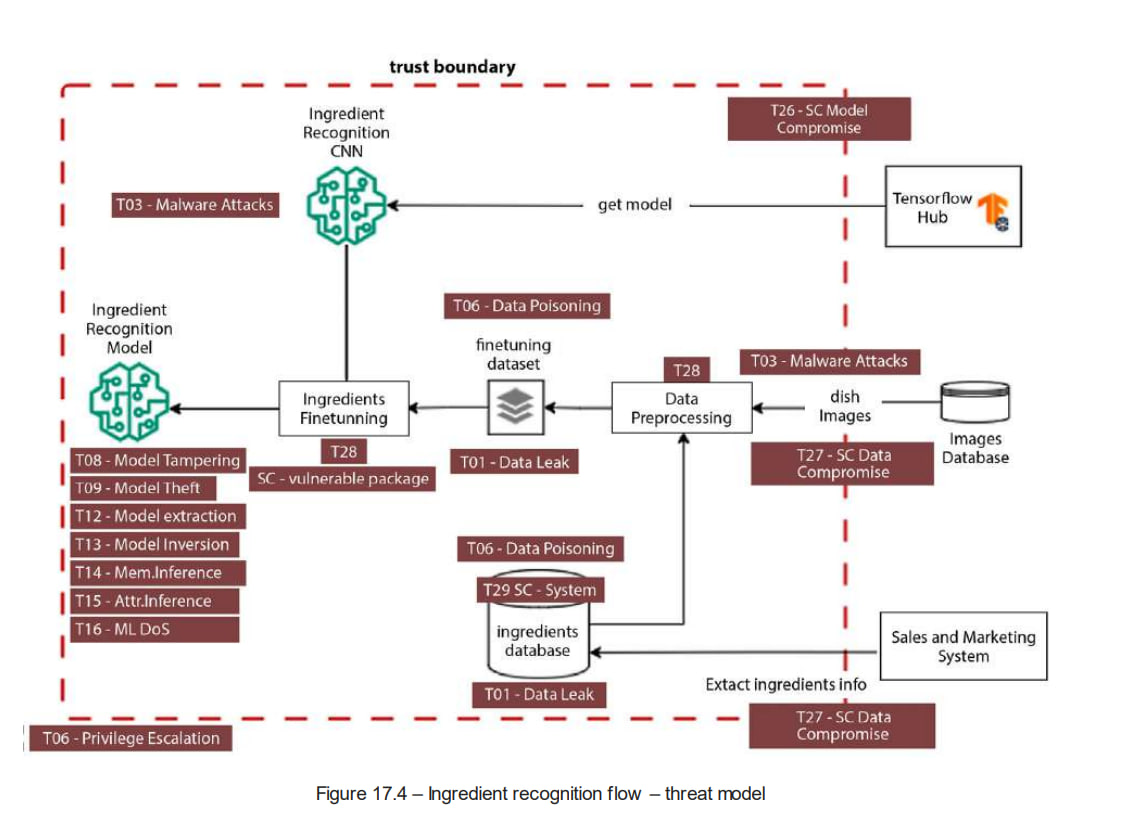

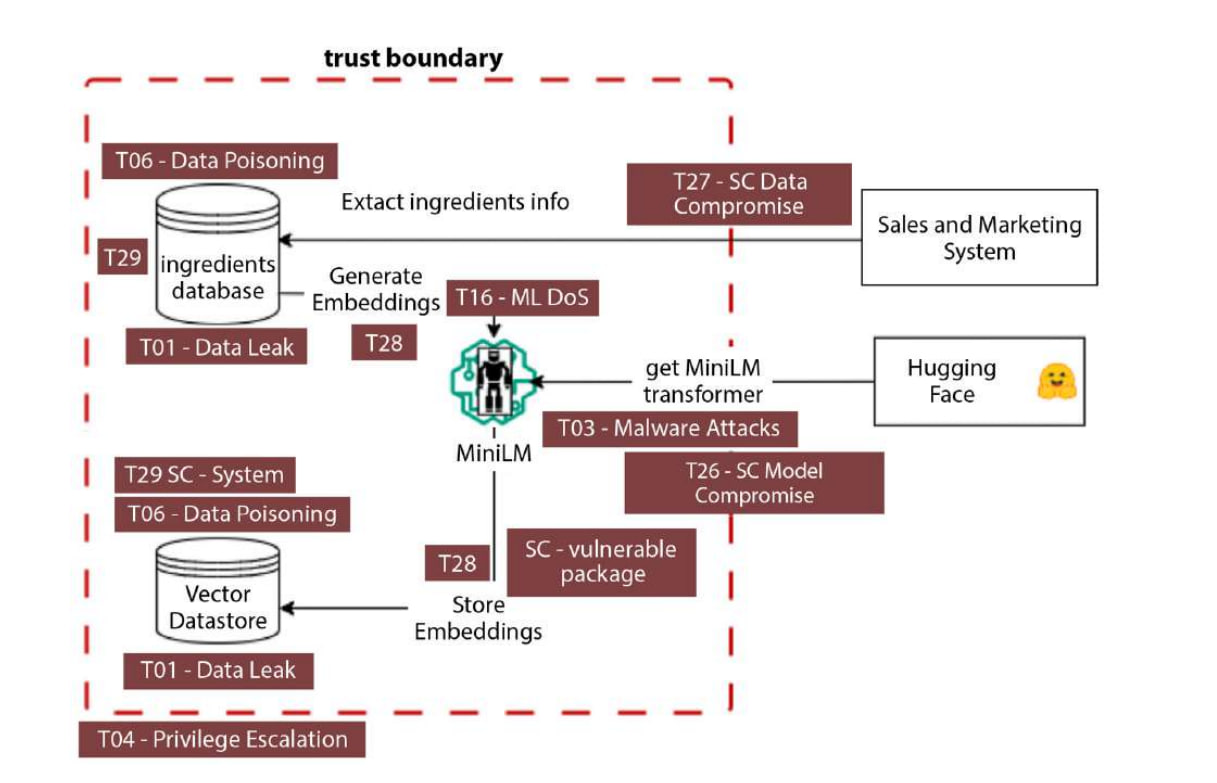

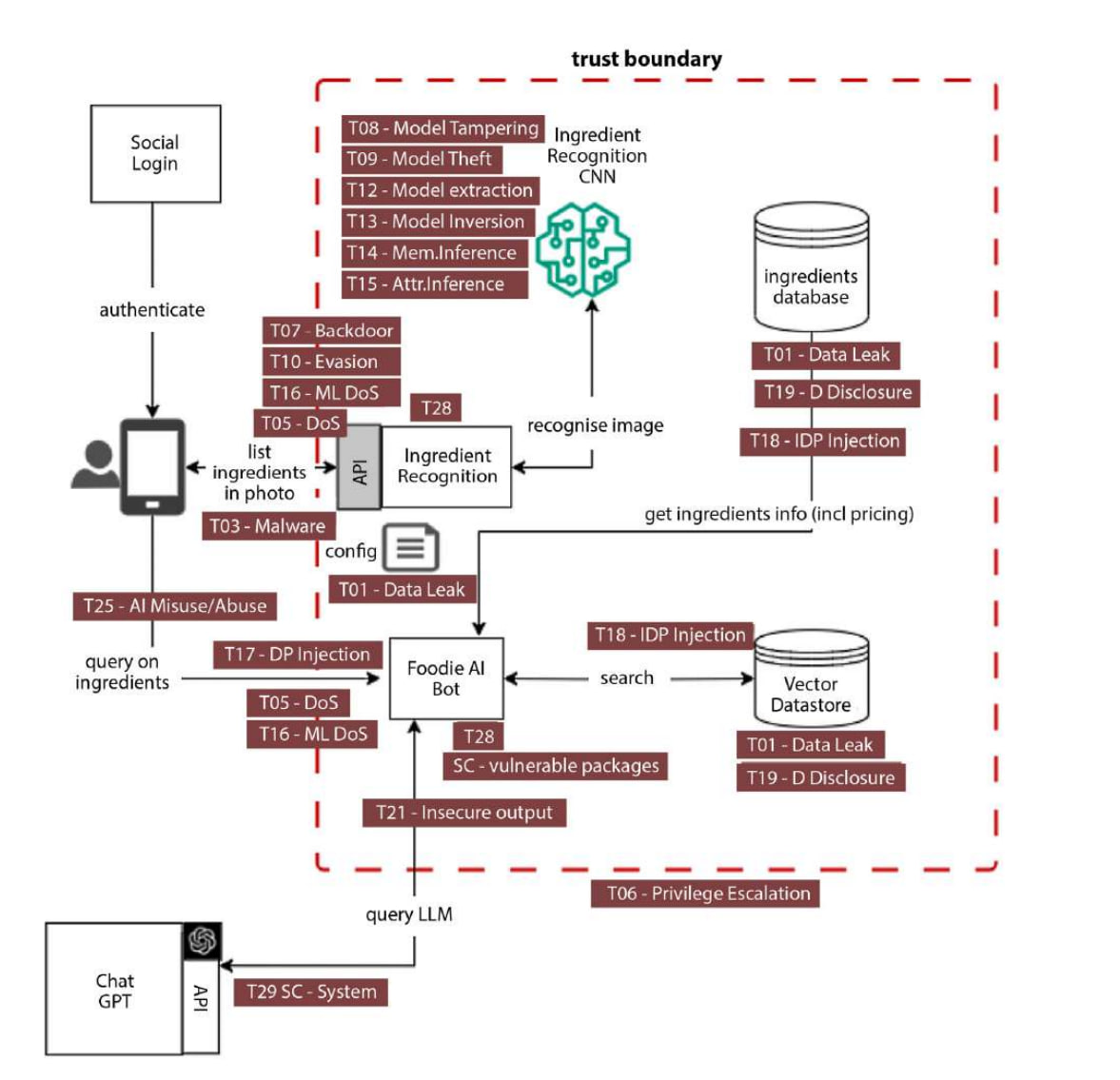

Моделирование угроз

больше в книге Adversarial AI Attacks, Mitigations, and Defense Strategies: A cybersecurity professional's guide to AI attacks, threat modeling, and securing AI with MLSecOps

Фреймворки по безопасности ML(Россия)

Векторы атак

Тут мы приводим полезный список ресурсов, которые посвящены конкретному вектору атаки.

Полноразмерная классификация тут

Блоги и публикации

🌱 Сообщество в сфере ИИ-безопасности растёт. Появляются новые блоги и исследования. В этом разделе вы можете найти и ознакомиться с примерами блогов в данной области, но это лишь малая часть, их намного больше.

- 🛡️ Red-Teaming Large Language Models

- 🔍 Google's AI red-team

- 🔒 The MLSecOps Top 10 vulnerabilities

- 🏴☠️ Token Smuggling Jailbreak via Adversarial Prompt

- ☣️ Just How Toxic is Data Poisoning? A Unified Benchmark for Backdoor and Data Poisoning Attacks

- 📊 We need a new way to measure AI security

- 🕵️ PrivacyRaven: Implementing a proof of concept for model inversion

- 🧠 Adversarial Prompts Engineering

- 🔫 TextAttack: A Framework for Adversarial Attacks, Data Augmentation, and Adversarial Training in NLP

- 📋 Trail Of Bits' audit of Hugging Face's safetensors library

- 🔝 OWASP Top 10 for Large Language Model Applications

- 🔐 LLM Security

- 🔑 Is you MLOps infrastructure leaking secrets?

- 🚩 Embrace The Red, blog where show how u can hack LLM's.

- 🎙️ Audio-jacking: Using generative AI to distort live audio transactions

- 🌐 HADESS - Web LLM Attacks

- 🧰 WTF-blog - MlSecOps frameworks ... Which ones are available and what is the difference?

- 📚 DreadNode Paper Stack

Инфраструктурные уязвимости MLOps

Очень интересные статьи по уязвимостям MlOps инфраструктуры. В некоторых можно найти даже готовые эксплоиты.

- SILENT SABOTAGE - Study on bot compromise for converting Pickle to SafeTensors

- NOT SO CLEAR: HOW MLOPS SOLUTIONS CAN MUDDY THE WATERS OF YOUR SUPPLY CHAIN - Study on vulnerabilities for the ClearML platform

- Uncovering Azure's Silent Threats: A Journey into Cloud Vulnerabilities - Study on security issues of Azure MLAAS

- The MLOps Security Landscape

- Confused Learning: Supply Chain Attacks through Machine Learning Models

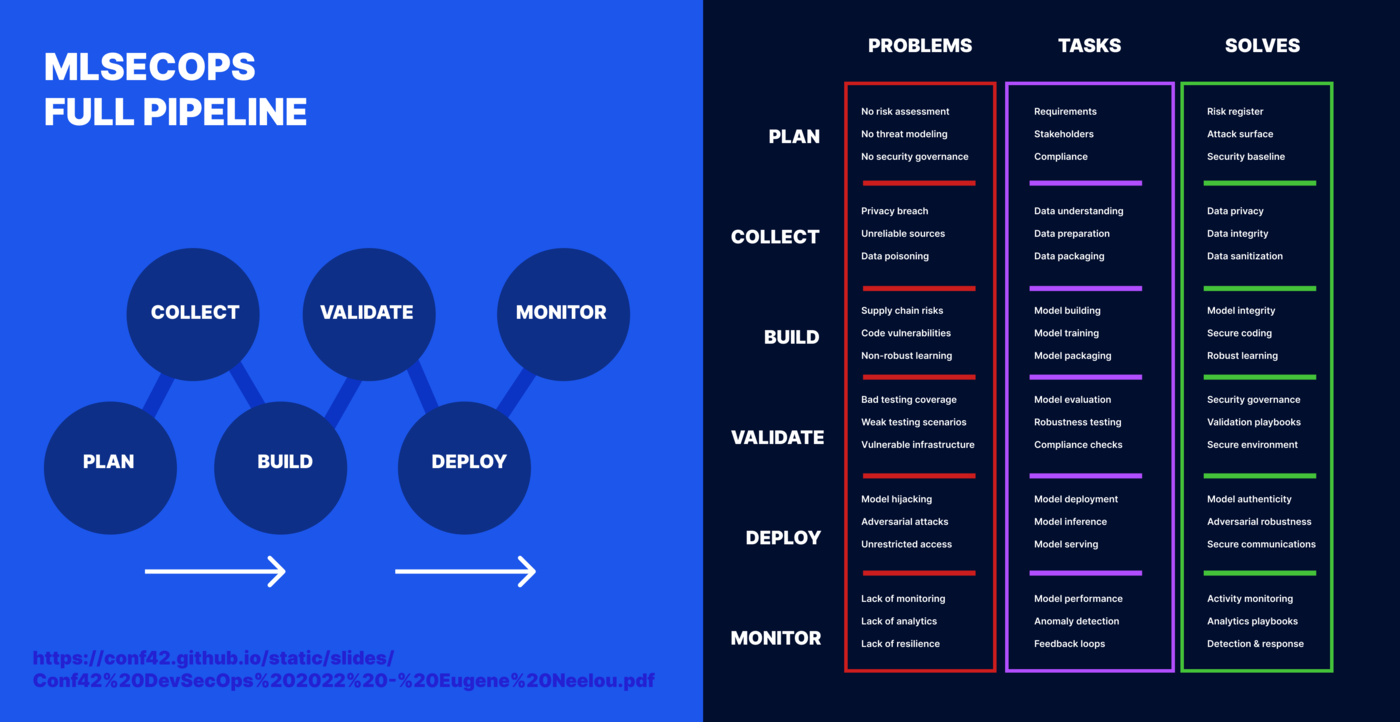

MlSecOps pipeline

Academic Po(C)ker FACE

Репозитории

Тут мы не стали переводить описания, так как могут возникнуть проблемы с пониманием.

| PoC | Описание |

|---|---|

| AgentPoison | Official implementation of "AgentPoison: Red-teaming LLM Agents via Memory or Knowledge Base Backdoor Poisoning". This project explores methods of data poisoning and backdoor insertion in LLM agents to assess their resilience against such attacks. |

| DeepPayload | Research on methods of embedding malicious payloads into deep neural networks. |

| backdoor | Investigation of backdoor attacks on deep learning models, focusing on creating undetectable vulnerabilities within models. |

| Stealing_DL_Models | Techniques for stealing deep learning models through various attack vectors, enabling adversaries to replicate or access models. |

| datafree-model-extraction | Model extraction without using data, allowing for the recovery of models without access to the original data. |

| LLMmap | Tool for mapping and analyzing large language models (LLMs), exploring the structure and behavior of various LLMs. |

| GoogleCloud-Federated-ML-Pipeline | Federated learning pipeline using Google Cloud infrastructure, enabling model training on distributed data. |

| Class_Activation_Mapping_Ensemble_Attack | Attack using ensemble class activation maps to introduce errors in models by manipulating activation maps. |

| COLD-Attack | Methods for attacking deep models under various conditions and constraints, focusing on creating more resilient attacks. |

| pal | Research on adaptive attacks on machine learning models, enabling the creation of attacks that can adapt to model defenses. |

| ZeroShotKnowledgeTransfer | Knowledge transfer in zero-shot scenarios, exploring methods to transfer knowledge between models without prior training on target data. |

| GMI-Attack | Attack for generating informative labels, aimed at covertly extracting data from trained models. |

| Knowledge-Enriched-DMI | Enhancing DMI (Data Mining and Integration) methods using additional knowledge to improve accuracy and efficiency. |

| vmi | Research on methods for visualizing and interpreting machine learning models, providing insights into model workings. |

| Plug-and-Play-Attacks | Attacks that can be "plugged and played" without needing model modifications, offering flexible and universal attack methods. |

| snap-sp23 | Tool for analyzing and processing snapshot data, enabling efficient handling of data snapshots. |

| privacy-vs-robustness | Research on the trade-offs between privacy and robustness in models, aiming to balance these two aspects in machine learning. |

| ML-Leaks | Methods for data leakage from trained models, exploring ways to extract private information from machine learning models. |

| BlindMI | Research on blind information extraction attacks, enabling data retrieval without access to the model's internal structure. |

| python-DP-DL | Differential privacy methods for deep learning, ensuring data privacy during model training. |

| MMD-mixup-Defense | Defense methods using MMD-mixup, aimed at improving model robustness against attacks. |

| MemGuard | Tools for protecting memory from attacks, exploring ways to prevent data leaks from model memory. |

| unsplit | Methods for merging and splitting data to improve training, optimizing the use of heterogeneous data in models. |

| face_attribute_attack | Attacks on face recognition models using attributes, exploring ways to manipulate facial attributes to induce errors. |

| FVB | Attacks on face verification models, aimed at disrupting authentication systems based on face recognition. |

| Malware-GAN | Using GANs to create malware, exploring methods for generating malicious code with generative models. |

| Generative_Adversarial_Perturbations | Methods for generating adversarial perturbations using generative models, aimed at introducing errors in deep models. |

| Adversarial-Attacks-with-Relativistic-AdvGAN | Adversarial attacks using Relativistic AdvGAN, exploring methods for creating more realistic and effective attacks. |

| llm-attacks | Attacks on large language models, exploring vulnerabilities and protection methods for LLMs. |

| LLMs-Finetuning-Safety | Safe fine-tuning of large language models, aiming to prevent data leaks and ensure security during LLM tuning. |

| DecodingTrust | Methods for evaluating trust in models, exploring ways to determine the reliability and safety of machine learning models. |

| promptbench | Benchmark for evaluating prompts, providing tools for testing and optimizing queries to large language models. |

| rome | Tool for analyzing and evaluating models based on ROM codes, exploring various aspects of model performance and resilience. |

| llmprivacy | Research on privacy in large language models, aiming to protect data and prevent leaks from LLMs. |

Решения для защиты LLM

| Название | Возможности безопасности LLM | URL |

|---|---|---|

| CalypsoAI Moderator | Фокусируется на предотвращении утечки данных, полной возможности аудита и обнаружении вредоносного кода. | https://calypsoai.com/ |

| Giskard | Система управления качеством ИИ для ML-моделей, которая фокусируется на уязвимостях, таких как предвзятость производительности, галлюцинации и инъекции промптов. | (https://www.giskard.ai/)[https://www.giskard.ai/] |

| Lakera | Lakera Guard повышает безопасность приложений LLM и противодействует широкому спектру кибер-угроз ИИ. | https://www.lakera.ai/ |

| Lasso Security | Фокусируется на LLM, предлагая оценку безопасности, продвинутое моделирование угроз и специализированные программы обучения. | https://www.lasso.security/ |

| LLM Guard | Разработан для укрепления безопасности LLM, предлагает санитизацию, обнаружение вредоносного языка, предотвращение утечки данных и устойчивость к инъекциям промптов. | https://llm-guard.com или https://github.com/laiyerai/llm-guard |

| LLM Fuzzer | Фреймворк с открытым исходным кодом для фаззинга, специально разработанный для LLM, который фокусируется на интеграции в приложения через API LLM. | https://github.com/llmfuzzer |

| Prompt Security | Предоставляет подход к обеспечению безопасности, конфиденциальности данных и безопасности во всех аспектах генеративного ИИ, не зависящий от конкретной LLM. | https://prompt.security |

| Rebuff | Самоукрепляющийся детектор инъекций промптов для AI-приложений, использующий многоуровневый механизм защиты. | https://github.com/rebuff |

| Robust Intelligence | Предоставляет AI-файрвол и непрерывное тестирование и оценку. Создатели базы данных airisk.io пожертвовали это MITRE. | https://www.robustintelligence.com/ |

| WhyLabs | Защищает LLM от угроз безопасности, фокусируясь на предотвращении утечки данных, мониторинге инъекций промптов и предотвращении дезинформации. | https://www.whylabs.ai/ |

Ресурсы сообщества

- MLSecOps

- MLSecOps Podcast

- MITRE ATLAS™ and SLACK COMMUNITY

- MlSecOps comuntiy and SLACK COMMUNITY

- OWASP Machine Learning Security Top Ten

- OWASP Top 10 for Large Language Model Applications

- OWASP LLMSVS

- OWASP Periodic Table of AI Security

-

OWASP SLACK

Следующие каналы:-

project-top10-for-llm

-

ml-risk-top5

-

project-ai-community

-

project-mlsec-top10

-

team-llm_ai-secgov

-

team-llm-redteam

-

team-llm-v2-brainstorm

-

- Hackstery

- PWNAI

- AiSec_X_Feed

- HUNTR Discord community

- AIRSK

- AI Vulnerability Database

- Incident AI Database

- Defcon AI Village CTF

- Awesome AI Security

- MLSecOps Reference Repository

- Awesome LVLM Attack

- Awesome MLLM Safety

- Телеграм папка

Книги и курсы

- Protect AI: Introduction to mlsecops

- Adversarial AI Attacks, Mitigations, and Defense Strategies: A cybersecurity professional's guide to AI attacks, threat modeling, and securing AI with MLSecOps

- Privacy-Preserving Machine Learning

- Generative AI Security: Theories and Practices (Future of Business and Finance)

- Lakera: Introduction to AI Security (10 days email course)

- The Developer's Playbook for Large Language Model Security

Инфографики

MLSecOps Lifecycle

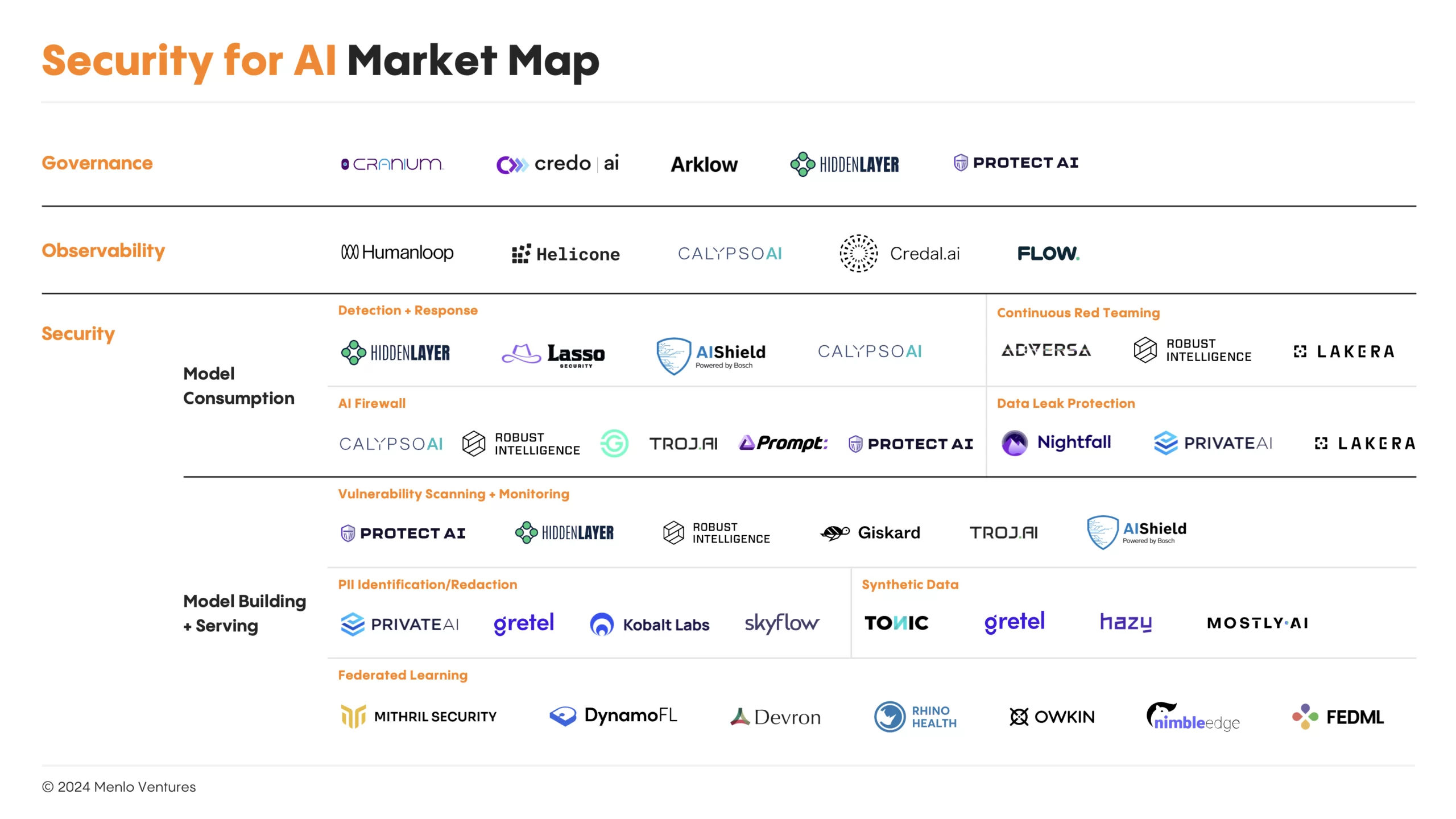

AI Security Market Map

Законодательство и постановления

| Страна | Название документа | Краткое описание | Основные направления | Ссылка |

|---|---|---|---|---|

| Россия | ИСКУССТВЕННЫЙ ИНТЕЛЛЕКТ. ТЕХНИЧЕСКАЯ СТРУКТУРА ФЕДЕРАТИВНОЙ СИСТЕМЫ МАШИННОГО ОБУЧЕНИЯ | Ссылка | ||

| Россия | ПНСТ 848-2023 Искусственный интеллект. Большие данные. Обзор и требования по обеспечению сохранности данных. | Ссылка | ||

| Россия | ПНСТ 847-2023 Искусственный интеллект. Большие данные. Функциональные требования в отношении происхождения данных | Ссылка | ||

| Россия | Оценка качества систем искусственного интеллекта. Общие положения. ГОСТ Р 59898-2021 | |||

| Россия | Информационные технологии. Интеллект искусственный. Оценка робастности нейронных сетей. Часть 1. Обзор. ГОСТ Р 70462.1-2022/ISO/IEC TR 24029-1-2021 | |||

| Россия | Системы искусственного интеллекта. Способы обеспечения доверия. Общие положения. ГОСТ Р 59276-2020 | |||

| США | Biden's AI executive order | Указ устанавливает новые стандарты безопасности ИИ, требуя от разработчиков мощных систем делиться результатами испытаний с правительством. | Министру торговли поручено разработать руководство и лучшие практики по безопасности ИИ в течение 270 дней. Подчеркивается важность безопасности и беспристрастности систем ИИ для национальной обороны и критической инфраструктуры. | Ссылка |

| США | FTC: Keep your AI claims in check | Ссылка | ||

| США | FAA - Unmanned Aircraft Vehicles | Ссылка | ||

| США | NHTSA - Automated Vehicle safety | Ссылка | ||

| США | AI Bill of Rights | Ссылка | ||

| Япония | Relaxing copyright for AI training | Economic growth takes priority over regulation | Ссылка | |

| Великобритания | AI white paper | Principle-based approach, decentralized governance | Ссылка | |

| Китай | Rules for GenAI services | Extraterritorial scope, content monitoring | Ссылка | |

| Сингапур | Voluntary AI Verify system | Self-assessment against principles, global alignment | ||

| Австралия | AI ethics framework | Voluntary principles, considering stricter laws | Ссылка | |

| Евросоюз | AI Act | Risk-based framework, banned uses, standards for high-risk AI | Ссылка | |

| Международный | ISO/IEC 42001 Artificial intelligence — Management system | Ссылка | ||

| Международный | ISO/IEC 22989 — Artificial intelligence — Concepts and terminology | Ссылка | ||

| Международный | ISO/IEC 38507 — Governance of IT — Governance implications of the use of artificial intelligence by organizations | Ссылка | ||

| Международный | ISO/IEC 23894 — Artificial Intelligence — Guidance on Risk Management | Ссылка | ||

| Международный | ANSI/UL 4600 Standard for Safety for the Evaluation of Autonomous Products | Addresses fully autonomous systems that move such as self-driving cars, and other vehicles including lightweight unmanned aerial vehicles (UAVs). | Includes safety case construction, risk analysis, design process, verification and validation, tool qualification, data integrity, human-machine interaction, metrics and conformance assessment. | Ссылка |